|

Introducción

En este artículo se intenta explicar cómo se deducen matemáticamente las fórmulas de los coeficientes que se utilizan frecuentemente en los modelos lineales por medio del método de lo mínimos cuadrados.

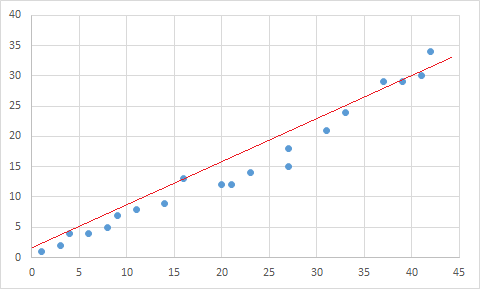

Cuando se tiene un conjunto de observaciones discretas, definidas por puntos se dice que existen curvas continuas que aproximan o se ajustan a ese conjunto de datos.

Dicha curva que tiene la propiedad de que $S=\sum_{i=0}^n d_i^2$, - la sumatoria de las distancias más cortas al cuadrado-, es un mínimo, se denomina curva de ajuste mínimo

Distancias más cortas del punto a la recta

Nótese que existen variadas técnicas para la estimación de parámetros de modelos líneales, i.e. Método de los Mínimos Cuadrados no es la única, sí es la más común donde se utilizan datos experimentales con aproximación discreta.

Descripción Simulador Gráfico Aleatorio y de Ajuste de Curvas.

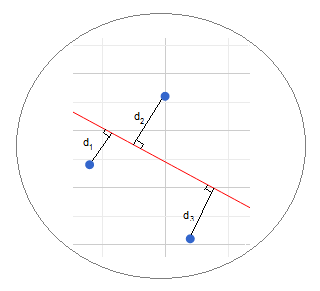

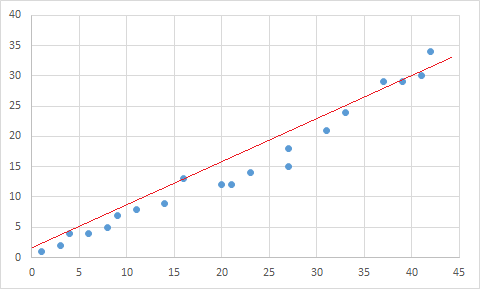

A continuación, se presenta un simulador gráfico construido sobre una tendencia con números enteros pseudo-aleatorios, los cuales se distribuyen dentro de un margen de variabilidad y patrón predeterminado en el plano cartesiano por un algoritmo desarrollado especialmente para esta presentación.

Por un lado el tamaño de la muestra $n\in N$ varía aleatoriamente entre ($5$ y $30$ puntos). Por otro lado los valores de sus coordenadas son aleatorias controladas sobre $R$. El propósito de experimentar con el concepto de ajuste de curvas por el método de los mínimos cuadrados.

En efecto, el gráfico que se genera está dotado de un panel de control que permite:

- Generar observaciones aleatorias,- sea con una tendencia de pendiente negativa o positiva-, y diagramar la curva de ajuste sobre esos puntos.

- Seleccionar el gráfico de dispersión de los puntos, (i.e. sólo desplegar sólo los puntos en el plano), sin aproximar o ajustar la curva más conveniente. Nótese que una vez desplegados aleatoriamente los puntos en el plano cartesiano, es posible fijar los datos y experimentar observando la curva que ajusta mejor, sea lineal simple, polinómica o exponencial. (Experimentar con el botón "Puntos").

¿Cuál curva aproxima mejor las observaciones de la primera gráfica?

- Seleccionar la curva que se aproxima en forma lineal simple, polinómica o exponencial, según lo seleccione el usuario. Nótese que si se posiciona el cursor sobre el punto o la curva, se muestra el par de coordenadas estimadas $(\hat x,\hat y)$ .

- Experimentar, observando el comportamiento con cada una de las tres curvas bajo los mismos datos. Esto se logra sólo eligiendo la opción "Fijas", en caso contrario los puntos se generan en "Random".

- Seleccionar la opción que permite obtener una tabla, - en la parte superior del gráfico -, con los datos $(x,y)$, donde el Dominio de Definición se encuentra dentro de $\unicode{123}x\in Z \text{ \ } -5\leq x \leq 30\unicode{125}$ y la Imagen $\unicode{123}y\in R\unicode{125}$. Inmediatamente debajo de la tabla de datos, se muestra la ecuación de la curva de ajuste $Y=f(x)$. (Ver checkbox Mostrar Datos).

Simulador de Puntos Aleatorios y Ajuste de Curvas ~ Plano Cartesiano

Curvas de Ajuste Mínimo

Entonces, con el Método de los Mínimos Cuadrados se puede ajustar una recta, una parábola, una isocuanta, etc.. Aquella que cumplen con esa propiedad se le llama por su forma "recta de ajuste mínimo", parábola de ajuste mínimo", "isocuanta de ajuste mínimo", etc..

A este efecto, se desarrollará la optimización de la función que involucra la suma del cuadrado de las mínimas distancias, - perpendiculares-, de un punto a una recta en el plano.

Con esta deducción se pretende facilitar la comprensión de un tratamiento de ajustes de funciones en varias variables e introducción al empleo estadístico de estas aproximaciones mediante regresiones lineales.

La técnica de mínimos cuadrados se usa en problemas de optimización en los ámbitos de las ciencias (física, química, economía, etc...), generalmente en forma estadística, trabajando sobre el error con métodos aleatorios y particularmente con las desviaciones de las observaciones con respecto a la media. Estos modelos lineales exigen una serie de condiciones y supuestos para ser aplicados (Teorema de Gauss-Márkov).

Los ejemplos que se abordan aquí, son conjuntos con un número finito de puntos, donde el sistema no está determinado, i.e. el polinomio conformado por estos datos no pasará exactamente por dichos puntos. Dicho de otra manera no serán curvas que interpolen los puntos.

Actualmente, estas estimaciones estadísticas de los parámetros de los modelos lineales se pueden realizar con diferentes métodos de aproximación cuantitativa con soporte de softwares existentes para dichos cálculos (Times-series, Cross-section Data, Panel Data, etc..), a fin de ajustar los datos localizados sobre el diagrama de dispersión.

En este caso, el enfoque es matemático con dos simples ejemplos formados por conjuntos de determinados puntos sobre el plano cartesiano y más adelante estos mismos ejemplos, se estimarán estadísticamente en el anexo de este artículo usando regresiones lineales con Excel, a fin de comparar los resultados.

Nótese que el presente documento está fuera del alcance de la identificación e hipótesis teóricas que se emplean, - en las diferentes disciplinas-, con la medición de estos parámetros, los cuales generalmente conciernen a relaciones con predicciones en función de esos los valores estimados con esas variables.

Se hace notar que el presente documento tampoco abarca el tratamiento del error, ni el análisis de varianza con la medición de los parámetros estimados con respecto a la media y una serie de indicadores estadísticos, etc... Es decir, aquí básicamente se enfoca en el planteamiento matemático en el método de deducción de los coeficientes de las curvas que aproximan la muestra.

Método Mínimos Cuadrados a Través de Ejemplos

Se aplicará un enfoque netamente didáctico, donde se puntualizan los datos en un diagrama de $2$ dimensiones, tomando dos variables al mismo tiempo, las cuales se les suele llamar variable "dependiente" ($Y$) y variable "independiente" ($X$). (Sin embargo, es más apropiado denominar $X$ como la variable que explica la variación de $Y$.)

Desarrollaremos un número determinado de ejemplos orientados a la

comprensión, comenzaremos con un ejemplo simple de una función

lineal en una sola variable para ir introduciendo la utilización de

métodos lineales y estimación de mínimos cuadrados en varias

variables.

Nótese que aquí se trabaja con sistemas de ecuaciones normales, que pueden ser múltiples de variables ($n\geq 2$ en $R^{n}$). Entonces, la solución pasará casi inevitablemente por un sistema cuadrado $n\times n$ de ecuaciones, el cual se verá reflejado en forma matricial $AX=B$.

Esta ecuación matricial, implica que se debe calcular la inversa $A^{-1}$. Es decir, se asume que se la $det(A)\neq 0$, i.e. las columnas de $A$ son linealmente independientes, de modo que el sistema de ecuaciones planteado es no singular y tiene una solución única.(Ver Ejemplo 2)

$$

\begin{cases}

\sum_{i=1}^n \alpha_{i1} x_{i} & = b_1 \\

\sum_{i=1}^n \alpha_{i2} x_{i} & = b_2 \\

\sum_{i=1}^n \alpha_{i3} x_{i} & = b_3 \\

\text{...} & \text{...}\\

\sum_{i=1}^n \alpha_{ij} x_{i} & = b_i \\

\text{...} & \text{...}\\

\sum_{i=1}^n \alpha_{in} x_{i} & = b_n \\

\end{cases}

$$

$\Rightarrow$

$$

\begin{pmatrix}

\alpha_{11} & \alpha_{12} & \alpha_{12} & \text{ ... } & \alpha_{1n}\\

\alpha_{21} & \alpha_{22} & \alpha_{22} & \text{ ... } & \alpha_{2n}\\

\alpha_{31} & \alpha_{32} & \alpha_{32} & \text{ ... } & \alpha_{3n}\\

& & & \text{ ... } & \\

\alpha_{n1} & \alpha_{n2} & \alpha_{n2} & \text{ ... } & \alpha_{nn}\\

\end{pmatrix}

\begin{pmatrix}

x_1\\

x_2\\

x_3\\

\text{......}\\

x_n\\

\end{pmatrix}

=

\begin{pmatrix}

b_1\\

b_2\\

b_3\\

\text{......}\\

b_n\\

\end{pmatrix}

$$

-

Ejemplo 1: con 3 Puntos

A continuación explicaremos el método de optimización o

búsqueda del mínimo, con un ejemplo de sólo tres observaciones sobre

el plano, a fin explicar en forma simple el método con que se

obtienen los coeficientes de la curva que mejor aproxima.

Obviamente, cuando se trabaja en tratamiento estadístico de datos el

tamaño de las muestras es considerablemente mayor. (Ver

Regresión Múltiple).

Supongamos tenemos tres observaciones en el plano cartesiano ($R^2$). Es

decir, tres pares ordenados de datos en los Reales ($R^2$) :

$$P_1 (1,1)$$

$$P_2 (2,3)$$

$$P_3 (4,3)$$

Deseamos buscar la recta $L$, que aproxime las observaciones

cumpliendo con la condición de los mínimos cuadrados. Es decir,

minimizando la sumatoria de las distancias al cuadrado, de los

puntos dados a dicha recta.

A ese efecto, construiremos una función $S$ de varias de variables,

la cual contenga la sumatoria de las desviaciones al cuadrado, que

optimizaremos, derivándola parcialmente e igualando a cero para

encontrar el mínimo.

Una vez determinada la función, mediante cálculos realizados

manualmente, estimaremos los coeficientes también mediante

regresiones con Excel. (Ver Anexo)

Donde $d_1, d_2, d_3$ son las distancias más cortas de los puntos

$P_1, P_2 \text{ y } P_3$ respectivamente a las recta $L$ que

deseamos determinar.

Sabemos que la distancia $d_i$ de un punto dado $(x_i , y_i)$ a una

recta dada $y = mx + b$ se calcula con la siguiente fórmula:

Donde $m$ es la pendiente y $b$ el intercepto de la recta en el eje

$y$

Sea $S(m,b)$ una función cuyas variables son la pendiente $m$ y el

intercepto de la recta $b$, que representa la suma de los cuadrados de

las distancias, de modo que:

$$ S(m,b)=\frac{1}{m^2+1}\sum_{i=1}^3 d_i^2\qquad\qquad[2]$$

Nota: La constante $\frac{1}{(m^2 + 1)}$ la obviaremos de la

función, dado que no aporta en el estudio de la variación que

realizaremos en la optimización de la función $[2]$.

Luego, utilizando las expresiones $[1A]$ y $[2]$, en un ejemplo con sólo $3$

observaciones. Digamos los puntos dados $P_1, P_2 \text{ y } P_3$,

-(Sustituyendo los puntos $(x_i,y_i)$ en el numerador de $[1A]$)-, la función a

optimizar adquiere la siguiente forma:

$$ S(m,b)=(m - 1 + b)^ 2 + (2m - 3 + b)^2 + (4m - 3 + b)^2$$

Derivando parcialmente la función $S(m,b)$ con respecto a $m$:

$$ \frac{\partial {S}}{\partial{m}}=(2·(m - 1 + b)·1) + (2·(2m - 3 +

b)·2) + (2·(4m - 3 + b)·4)$$

$\Rightarrow$

$$ \frac{\partial {S}}{\partial{m}}=42m + 14b - 28 $$

$$S'_m=42m + 14b - 28\qquad\qquad[2.1]$$

Ahora, derivando parcialmente la función $S(m,b)$ con respecto a $b$:

$$ \frac{\partial {S}}{\partial{b}}=2(m - 1+ b) + 2(2m - 3 + b) +

2(4m - 3 + b) $$

$$S'_b=14m + 6b - 14\qquad\qquad[2.2]$$

|

|

Por tanto igualando a cero las derivadas $[2.1]$ y $[2.2]$ se obtiene el

siguiente sistema de ecuaciones:

|

|

| $$21 m + 7 b = 14$$ |

|

| |

$$[2.3]$$ |

| $$7 m + 3 b = 7$$ |

|

|

|

$\Rightarrow$

$$m =\frac{4}{7} \quad \text{ y }\quad b =1$$

Es decir, el punto $Q = (\frac{4}{7}, 1)$ minimiza la función $S(m,b)$

Por tanto la recta buscada $L$ es:

$$y = \frac{4}{7} x + 1$$

Luego, $L$ es la función lineal que cumple las condiciones de lo mínimos

cuadrados para los puntos dados en el plano cartesiano ($R^2$). Nótese que $Q$ es un

punto crítico de $S$, puesto que las derivadas parciales de primer orden de $S$

están definidas en todos los puntos de una región del plano $xy$, y $Q$ es el

extremo relativo de $S$ en la región donde están situados en puntos críticos.

-

Extensión del Método de Cálculo a $n$ Observaciones

Ahora, extendamos y exploremos métodos de estimación de la pendiente $m$ y el

intercepto $b$ de la recta para una serie de puntos $P_i=(x_i,y_i)$ en el plano

cartesiano, tal que $n\in N \land n>2$.

Luego, sea $L$ de la forma $y=m x + b$ que cumple con las condiciones de

optimizar minimizando la sumatoria de las distancias al cuadrado, desde los

puntos dados a dicha recta que deseamos determinar.

Donde $d_1,d_2,d_3,\text{ ... }d_n$ son las distancias más cortas de los puntos

$P_1,P_2,P_3,\text{ ... }d_n$ respectivamente a las recta $L$ que deseamos

determinar.

Desde la fórmula rotulada con $[1A]$, sabemos que la distancia $d_i$ de un punto

dado $(x_i , y_i)$ a una recta dada $y = mx + b$ se calcula con la siguiente

fórmula:

$$ d_i=\frac{|mx_i-y_i + b|}{\sqrt{m^{2}+1}}$$

Luego, se obtiene una extensión del ejemplo $[2]$ $\forall n \gt 1$. La función a optimizar es:

$$ S(m,b)=\frac{1}{m^2+1}\sum_{i=1}^n d_i^2\qquad\qquad[3]$$

Sus derivadas parciales son:

$$ \frac{\partial {S}}{\partial{m}}=2\sum_{i=1}^n x_i(mx_i - y_i + b) $$

$\Rightarrow$ $$ \frac{\partial {S}}{\partial{m}}=2\sum_{i=1}^n x_i d_i $$

$$ \frac{\partial {S}}{\partial{b}}=2\sum_{i=1}^n (mx_i - y_i + b) $$

$\Rightarrow$ $$ \frac{\partial {S}}{\partial{b}}=2\sum_{i=1}^n d_i $$

Notas

- La constante $\frac{1}{(m^2 + 1)}$ la obviaremos de la

función, dado que no aporta en el estudio de la variación que

realizaremos en la optimización de la función $[2]$.

-No olvidar aplicar la regla de la cadena, con el coeficiente $x_i\in R$ de la variable $m$

De estas expresiones, igualando $S'_m=S'_b$ y siguiendo las pautas vistas en

$[2.1],\quad [2.2], \quad [2.3]$ se deducen, - despejando con una serie de operaciones algebraicas-, las constantes $m$ y $b$ de la recta

que aproxima el conjunto de puntos $P(x_i,y_i)$ definido por:

$$ Y = mX + b

\qquad\qquad[4] $$

Donde $X$ e $Y$ son los vectores con sus elementos respectivos, i.e

$X=\unicode{123}x_1,x_2,x_3,\text{ ... },x_n\unicode{125}\quad$ y $\quad

Y=\unicode{123}y_1,y_2,y_3,\text{ ... },y_n\unicode{125}$

En efecto, las contantes $m$ y $b$ se determinan resolviendo el sistema de ecuaciones lineales:

| $$\sum_{i=1}^n Y=b·n + m\sum_{i=1}^n X$$ |

| |

$[5]$ |

| $$\sum_{i=1}^n XY=b\sum_{i=1}^n X + m\sum_{i=1}^n X^2$$ |

Las dos expresiones rotuladas con $[5]$ se denominan ecuaciones normales

para la recta de mínimos cuadrados. .

Al comenzar a despejar operando algebraicamente este sistema de ecuaciones

$[5]$, se obtienen tanto la pendiente $m$ como $b$ en función de la diferentes

y combinadas sumatorias en $X$ e $Y$. A saber:

| |

|

| $$m=\frac{n\sum_{i=1}^n XY-(\sum_{i=1}^n X)(\sum_{i=1}^n Y)}

{n\sum_{i=1}^n X^2-(\sum_{i=1}^n X^2)}$$ |

|

| |

$$[6]$$ |

| $$b=\frac{n\sum_{i=1}^n Y (\sum_{i=1}^n X^2)-(\sum_{i=1}^n X)(\sum_{i=1}^n

XY)} {n\sum_{i=1}^n X^2-(\sum_{i=1}^n Y)}$$ |

|

| |

|

- Ejemplo 2: con 8 Puntos

Consideremos $n=8$ puntos u observaciones en el plano:

|

$X$ |

$Y$ |

$$X^2$$ |

$XY$ |

$$Y^2$$ |

1 |

1 |

1 |

1 |

1 |

|

3 |

2 |

9 |

6 |

4 |

|

4 |

4 |

16 |

16 |

16 |

|

6 |

4 |

36 |

24 |

16 |

|

8 |

5 |

64 |

40 |

25 |

|

9 |

7 |

81 |

63 |

49 |

|

11 |

8 |

121 |

88 |

64 |

|

14 |

9 |

196 |

126 |

81 |

|

$$\sum_{i=1}^n X_i= 56$$

|

$$\sum_{i=1}^n Y_i=40$$ |

$$\sum_{i=1}^n X_i^2=524$$ |

$$\sum_{i=1}^n X_i Y_i=364$$ |

$$\sum_{i=1}^n Y_i^2=256$$ |

Resolvamos la búsqueda de la recta de mínimos cuadrados, despejando $m$ y $b$,

del sistema de ecuaciones rotulado como $[5]$

| $$\sum_{i=1}^n Y=b·n + m\sum_{i=1}^n X$$ |

|

| $$40=8·b + m· 56$$ |

|

| |

$$\leftarrow \text{ aplicando }[5]$$ |

| $$\sum_{i=1}^n XY=b\sum_{i=1}^n X + m\sum_{i=1}^n X^2$$ |

|

| $$364=56·b + m·524$$ |

|

Se representa el sistema de ecuaciones matricialmente, a fin de resolver el

sistema de ecuaciones $[5]$. Entonces:

$$A$$

|

$$B?$$ |

$$C$$ |

$$\downarrow$$

|

$$\downarrow$$ |

$$\downarrow$$ |

| $$\begin{pmatrix} 8 & 56\\ 56 & 524\\ \end{pmatrix}$$ |

$$\begin{pmatrix} b\\ m\\ \end{pmatrix}$$ |

$$=\begin{pmatrix} 40\\ 364\\ \end{pmatrix}$$ |

Calculando la inversa $A^{-1}$, se obtiene:

$$ A^{-1}= \begin{pmatrix} 0,496212121 & -0,053030303\\ -0,05303030 &

0,007575758\\ \end{pmatrix} $$

Luego, aplicando la inversa, se tiene $A^{-1}AB=A^{-1}C,\quad \Rightarrow\quad

B=A^{-1}C$

$$ B= \begin{pmatrix} 0,496212121 & -0,053030303\\ -0,05303030 & 0,007575758\\

\end{pmatrix} \begin{pmatrix} 291\\ 11993\\ \end{pmatrix} = \begin{pmatrix}

0,545454545\\ 0,636363636\\ \end{pmatrix} $$

$\Rightarrow$

| $$b=0,636363636$$ |

$$m=0,545454545$$ |

$$\Rightarrow$$

|

|

|

$Y=0,636363636·X + 0,545454545$

|

Es decir, el punto $Q = (0,636363636, 0,545454545)$ minimiza la función $S(m,b)$ ($\quad Ver[3]$).

|